1. Введение

1.1 Определение Big Data и Data Science

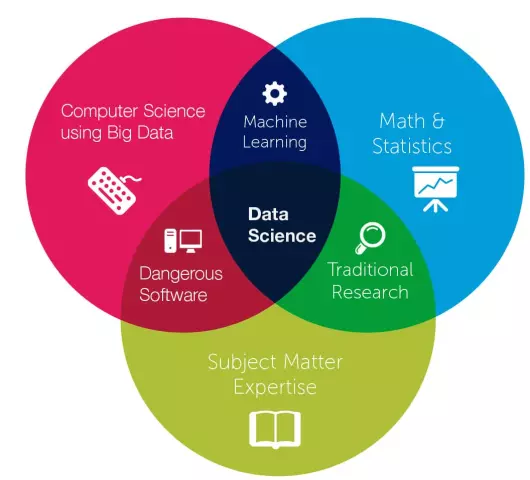

Big Data - это термин, обозначающий чрезвычайно большие и сложные наборы данных, которые традиционные методы обработки данных не могут эффективно анализировать. Data Science представляет собой междисциплинарную область, которая использует научные методы, алгоритмы, процессы и системы для извлечения знаний и ценной информации из данных.

1.2 Роль Big Data и Data Science в современном мире

Современный мир характеризуется беспрецедентным ростом объемов генерируемых данных. Данные поступают из самых разнообразных источников: социальных сетей, датчиков Интернета вещей, транзакций, медицинских исследований и так далее. Обработка и анализ таких массивов данных традиционными методами неэффективны. Big Data и Data Science предоставляют инструменты и методики для извлечения ценной информации из этих огромных наборов данных.

Алгоритмы машинного обучения, работающие с большими объемами данных, способны выявлять скрытые закономерности, прогнозировать будущие события и принимать оптимальные решения. Применение Big Data и Data Science позволяет компаниям оптимизировать бизнес-процессы, персонализировать предложения для клиентов, разрабатывать новые продукты и услуги, а также получать конкурентные преимущества.

В различных отраслях, таких как здравоохранение, финансы, производство и розничная торговля, Big Data и Data Science играют все более важную роль. Они способствуют улучшению качества обслуживания, повышению эффективности работы и принятию более обоснованных решений.

2. Этапы извлечения ценной информации из данных

2.1 Сбор и хранение данных

Сбор данных осуществляется с использованием разнообразных источников, таких как базы данных, API, файлы журналов, сенсоры и социальные сети. Выбор конкретных источников зависит от целей анализа и доступности информации. После сбора данные необходимо хранить в структурированном формате, оптимизированном для последующей обработки. Для этого используются системы управления базами данных (СУБД), облачные хранилища или специализированные платформы для хранения Big Data, такие как Hadoop Distributed File System (HDFS). Эффективность хранения данных напрямую влияет на производительность анализа и возможность извлечения ценной информации.

2.2 Обработка и очистка данных

Обработка и очистка данных является критически важным этапом в любом проекте, связанном с анализом данных. Сырые данные часто содержат ошибки, пропуски, дубликаты и несогласованности, которые могут привести к искаженным результатам анализа.

Процесс обработки данных включает в себя ряд шагов, таких как удаление дубликатов, заполнение пропущенных значений, преобразование типов данных, стандартизация форматов и выявление и устранение выбросов. Очистка данных направлена на повышение качества данных, делая их пригодными для последующего анализа.

Выбор конкретных методов обработки и очистки зависит от характера данных, целей анализа и доступных инструментов. Использование специализированного программного обеспечения и алгоритмов машинного обучения может автоматизировать и оптимизировать этот процесс.

2.3 Анализ данных

Анализ данных представляет собой процесс преобразования сырых данных в осмысленную информацию с целью выявления тенденций, закономерностей и взаимосвязей. Он включает в себя ряд этапов, таких как сбор, очистка, трансформация, анализ и визуализация данных. Методы анализа данных варьируются от статистического моделирования до машинного обучения и глубокого обучения. Выбор подходящего метода зависит от типа данных, поставленных задач и доступных ресурсов. Результаты анализа данных могут быть использованы для принятия обоснованных решений, оптимизации процессов, прогнозирования будущих событий и создания новых продуктов или услуг.

2.4 Визуализация и интерпретация результатов

Визуализация играет ключевую роль в процессе интерпретации результатов анализа данных. Графическое представление данных позволяет выявлять закономерности, тренды и аномалии, которые могут быть не очевидны при просмотре сырых данных. Выбор подходящего типа визуализации зависит от характера данных и поставленных задач. Например, для демонстрации распределения данных используются гистограммы и ящичковые диаграммы, для отображения взаимосвязей между переменными - точечные диаграммы, а для представления временных рядов - линейные графики. Инструменты визуализации, такие как matplotlib, seaborn и Tableau, предоставляют широкий спектр возможностей для создания информативных и наглядных графиков.

Интерпретация результатов анализа данных требует глубокого понимания предметной области и статистических методов. Необходимо оценить достоверность полученных выводов, а также учесть возможные ограничения и предвзятости в данных. Результаты анализа следует интерпретировать в контексте бизнес-задач и целей исследования.

3. Методы и инструменты Data Science

3.1 Машинное обучение

Машинное обучение (Machine Learning, ML) - это подраздел искусственного интеллекта, который занимается созданием алгоритмов, способных обучаться на данных без явного программирования. ML-алгоритмы могут выявлять закономерности, прогнозировать будущие события и принимать решения на основе предоставленных данных. Существует три основных типа обучения:

- Обучение с учителем (Supervised Learning): Алгоритм обучается на размеченных данных, где каждый пример имеет входные признаки и соответствующий выходной ярлык. Цель - научиться предсказывать ярлыки для новых, невиданных примеров.

- Обучение без учителя (Unsupervised Learning): Алгоритм обучается на неразмеченных данных, пытаясь найти скрытые структуры, группировать похожие объекты или выявлять аномалии.

- Обучение с подкреплением (Reinforcement Learning): Алгоритм учится взаимодействуя с окружающей средой и получая вознаграждения за желаемое поведение. Цель - найти оптимальную стратегию действий для максимизации суммарного вознаграждения.

Выбор типа обучения зависит от задачи и доступных данных. ML-алгоритмы широко используются в различных областях, таких как прогнозирование спроса, обнаружение мошенничества, персонализация рекомендаций, обработка естественного языка и компьютерное зрение.

3.2 Глубокое обучение

Глубокое обучение (Deep Learning) - это подклас машинного обучения, использующий искусственные нейронные сети с множеством слоев для анализа данных. Эти сети вдохновлены структурой и функцией человеческого мозга, способны обучаться на огромных объемах данных и выявлять сложные закономерности. Глубокое обучение успешно применяется в задачах классификации изображений, распознавания речи, обработки естественного языка, прогнозирования временных рядов и других областях, требующих анализа и интерпретации больших объемов информации.

3.3 Статистический анализ

Статистический анализ является ключевым этапом в процессе извлечения ценной информации из данных. Он включает в себя применение различных статистических методов для описания, анализа и интерпретации данных. К распространенным методам относятся:

- Описательная статистика: определяет основные характеристики набора данных, такие как среднее значение, медиана, стандартное отклонение, квартили и так далее.

- Инференциальная статистика: используется для выводов о генеральной совокупности на основе выборки данных. Включает в себя гипотезы, тесты значимости и интервалы доверия.

- Регрессионный анализ: изучает взаимосвязь между переменными. Позволяет прогнозировать значение одной переменной на основе значений других.

- Кластерный анализ: группирует объекты данных по сходству.

Выбор конкретных методов статистического анализа зависит от типа данных, поставленных задач и желаемого результата.

3.4 Инструменты для работы с Big Data

Для обработки и анализа больших объемов данных (Big Data) используются специализированные инструменты. К ним относятся системы распределенной файловой системы, такие как Hadoop Distributed File System (HDFS), базы данных NoSQL, например Cassandra или MongoDB, платформы для обработки потоковых данных, например Apache Kafka, и фреймворки для параллельной обработки данных, такие как Apache Spark и Apache Flink. Выбор конкретного инструмента зависит от объема данных, типа задач анализа и требований к производительности.

4. Примеры применения Big Data и Data Science

4.1 Бизнес-аналитика

Бизнес-аналитика использует методы Data Science для анализа бизнес-данных с целью выявления тенденций, паттернов и अंतрящихся взаимосвязей. Результаты такого анализа применяются для принятия обоснованных бизнес-решений, оптимизации процессов, повышения эффективности и конкурентоспособности. Ключевые инструменты бизнес-аналитики включают статистический анализ, машинное обучение, визуализацию данных и прогнозное моделирование.

4.2 Медицина и здравоохранение

Анализ медицинских данных, включая электронные истории болезни, результаты лабораторных исследований и данные о генетике пациентов, позволяет выявлять закономерности и тенденции в развитии заболеваний. Машинное обучение может быть использовано для прогнозирования риска развития определенных патологий, персонализации лечения и оптимизации процессов оказания медицинской помощи. Применение алгоритмов компьютерного зрения в анализе медицинских изображений (рентгеновских снимков, КТ, МРТ) способствует более точной диагностике и планированию хирургических вмешательств.

4.3 Финансы

Финансовая сфера активно использует методы анализа больших данных для принятия более обоснованных решений. Прогнозирование рыночных тенденций, оценка рисков инвестиций, выявление мошеннических операций - все эти задачи могут быть решены с помощью алгоритмов машинного обучения, работающих на массивах финансовых данных. Анализ исторических ценовых данных, новостных лент и социальных сетей позволяет прогнозировать будущие движения рынка с большей точностью. Модели машинного обучения способны выявлять скрытые закономерности в финансовых данных, что помогает инвесторам принимать более взвешенные решения. Кроме того, анализ транзакционных данных может помочь банкам и другим финансовым учреждениям выявлять и предотвращать мошеннические операции.

4.4 Маркетинг

Маркетинговая аналитика, основанная на обработке больших объемов данных, позволяет сегментировать аудиторию с высокой точностью, определять предпочтения потребителей, прогнозировать спрос и оптимизировать рекламные кампании. Анализ поведенческих данных пользователей в онлайн-среде (история просмотров, клики, время пребывания на страницах) помогает персонализировать маркетинговые сообщения и повысить их эффективность. Модели машинного обучения могут предсказывать вероятность покупки, выявлять лояльных клиентов и определять оптимальные каналы коммуникации. Использование данных о демографических характеристиках, интересах и привычках покупателей позволяет создавать таргетированную рекламу, которая достигает нужной аудитории с большей точностью.